自從 1981 年 IBM 推出第一台 PC-5150 個人電腦以來,至今已超過三十年。從早期的紙卡、磁帶、磁碟片,到現在普及的硬碟、光碟、雲端儲存設備。每天每人所會應用到的資料儲存容量,從平均幾百位元組、到現在每天近三百萬兆位元組。

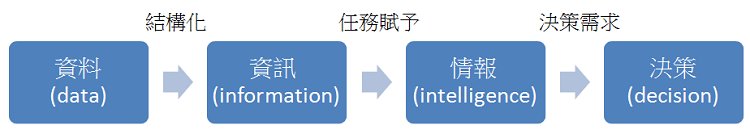

這麼多的資料,要如何轉變成我們所需要的資訊呢?而整理後的資訊又要如何轉換成協助企業決策所需要的情報?我們今天來談談海量資料,相信可以為閱聽者提供解答。

Big Data

海量資料( Big Data )根據維基百科的定義,指的是所涵蓋之資料量規模大到難在合理時間內進行「擷取」、「管理」、「處理」、並「整理」成企業經營決策所需的資訊。另根據 IBM 的定義,海量資料有四個特性:

- 資料龐「大」(Volume)

- 變化飛「快」(Velocity)

- 種類繁「雜」(Variety)

- 真偽存「疑」(Veracity)

簡而言之,海量資料處於資訊爆炸的年代,其特性變的又多、又快、又雜,又真偽難分。

於是,各個企業在自有資訊平台已然成熟之時,企業內部所擁有的資料量已難以估計,且成長快速,舉例來說:掏寶網站每天有超過數千萬筆的交易量,這些交易會在系統上每天產生超過 50TB 的資料量,約 40PB 的儲存量。而具賽門鐵克公司的研究報告,全球企業的資訊儲存總量已達 2.2ZB ,年增 67% 。另外換以網路連接數量來說, 2007 年全球約有五億個設備連網、而到了 2013 年已成長到五百億個。同時因寬頻網路越來越普及,每人平均使用網路之流量也迅速提升,每天全球在資料膨脹的速度與數量,著實難以估計。

我們可以看出數據規模越大、處理的難度也相對提高不少,尤其這些資料量每年是以高倍數的方式成長。因此,對這些資料進行探勘採集、分析重整等工作所產生的價值更高。

以上得到一個結論,在這麼複雜的海量資料環境,若能進一步分析企業所需的資料,快速得到決策所需情報,會是未來企業決策致勝關鍵。

資料分析之目的,最終為提供決策所需之正確情報,重新建構、或提升海量資料分析能力為未來企業在資訊進化過程需要關注之重點。

我們近年面對客戶在龐大資料分析、處理、加值應用方面累積許多成功案例。若有類似需求或想法,歡迎與我們交流。